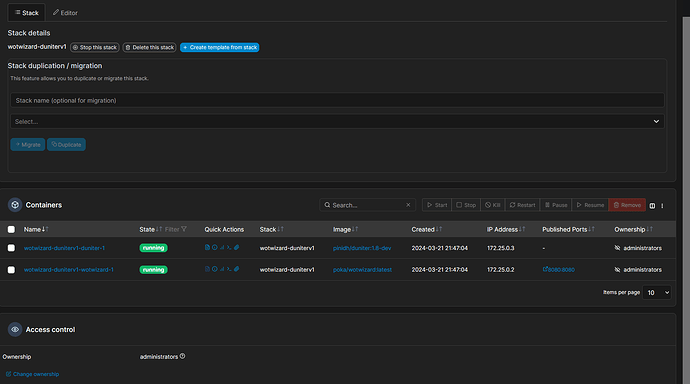

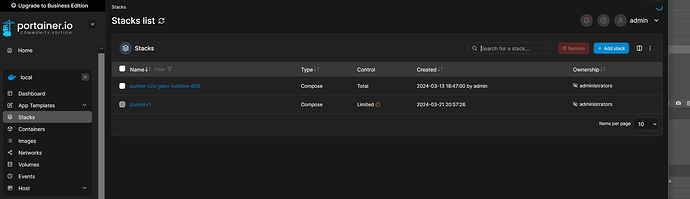

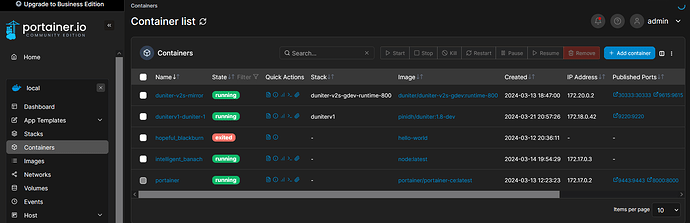

Cela ma crée deux containers:

Le premier à l’air de bien tourner

2024-03-21T20:51:50+00:00 - trace: BenoitLeBars was affected wotb_id 1207

2024-03-21T20:51:50+00:00 - trace: Cat was affected wotb_id 1208

2024-03-21T20:51:50+00:00 - trace: LucieHaget was affected wotb_id 1209

2024-03-21T20:51:50+00:00 - trace: jbboyer was affected wotb_id 1210

2024-03-21T20:51:50+00:00 - debug: Total tx count: 10842

2024-03-21T20:51:50+00:00 - trace: Trim indexes below block #132084

2024-03-21T20:51:50+00:00 - trace: Boblac was affected wotb_id 1211

2024-03-21T20:51:50+00:00 - trace: PHILOU was affected wotb_id 1212

2024-03-21T20:51:50+00:00 - trace: LionelJousset was affected wotb_id 1213

2024-03-21T20:51:50+00:00 - info: Milestones 19%, Downloaded 19%, Applied 19%

2024-03-21T20:51:50+00:00 - debug: Total tx count: 10857

2024-03-21T20:51:50+00:00 - trace: Gavy was affected wotb_id 1214

2024-03-21T20:51:50+00:00 - trace: JeanBaptisteLeDevehat was affected wotb_id 1215

2024-03-21T20:51:50+00:00 - trace: Trim indexes below block #132364

2024-03-21T20:51:50+00:00 - trace: Enthea was affected wotb_id 1216

2024-03-21T20:51:50+00:00 - trace: imani was affected wotb_id 1217

2024-03-21T20:51:50+00:00 - debug: Total tx count: 10872

2024-03-21T20:51:50+00:00 - trace: LucaHeine was affected wotb_id 1218

2024-03-21T20:51:50+00:00 - trace: Trim indexes below block #132625

2024-03-21T20:51:50+00:00 - trace: Jsln was affected wotb_id 1219

2024-03-21T20:51:52+00:00 - info: Getting chunk #532/2855 from 133000 to 133249 on peer g1.brussels.ovh

2024-03-21T20:51:52+00:00 - info: Getting chunk #533/2855 from 133250 to 133499 on peer g1v1.p2p.legal

2024-03-21T20:51:52+00:00 - info: Getting chunk #536/2855 from 134000 to 134249 on peer g1.cgeek.fr

2024-03-21T20:51:52+00:00 - info: Getting chunk #537/2855 from 134250 to 134499 on peer duniter-v1-g1.axiom-team.fr

2024-03-21T20:51:52+00:00 - info: Getting chunk #538/2855 from 134500 to 134749 on peer duniter.econolib.re

2024-03-21T20:51:52+00:00 - info: GOT chunk #532/2855 from 133000 to 133249 on peer g1.brussels.ovh

2024-03-21T20:51:52+00:00 - info: GOT chunk #533/2855 from 133250 to 133499 on peer g1v1.p2p.legal

2024-03-21T20:51:52+00:00 - info: Getting chunk #535/2855 from 133750 to 133999 on peer g1.brussels.ovh

2024-03-21T20:51:52+00:00 - info: Getting chunk #534/2855 from 133500 to 133749 on peer g1v1.p2p.legal

2024-03-21T20:51:52+00:00 - info: Getting chunk #539/2855 from 134750 to 134999 on peer duniter.pini.fr

2024-03-21T20:51:52+00:00 - info: GOT chunk #536/2855 from 134000 to 134249 on peer g1.cgeek.fr

2024-03-21T20:51:52+00:00 - debug: Total tx count: 10893

2024-03-21T20:51:52+00:00 - info: GOT chunk #537/2855 from 134250 to 134499 on peer duniter-v1-g1.axiom-team.fr

2024-03-21T20:51:53+00:00 - info: GOT chunk #535/2855 from 133750 to 133999 on peer g1.brussels.ovh

2024-03-21T20:51:53+00:00 - info: GOT chunk #534/2855 from 133500 to 133749 on peer g1v1.p2p.legal

2024-03-21T20:51:53+00:00 - info: GOT chunk #538/2855 from 134500 to 134749 on peer duniter.econolib.re

2024-03-21T20:51:53+00:00 - trace: Trim indexes below block #132891

2024-03-21T20:51:53+00:00 - trace: oceane was affected wotb_id 1220

2024-03-21T20:51:53+00:00 - info: GOT chunk #539/2855 from 134750 to 134999 on peer duniter.pini.fr

2024-03-21T20:51:53+00:00 - debug: Total tx count: 10918

2024-03-21T20:51:53+00:00 - trace: themouette was affected wotb_id 1221

2024-03-21T20:51:53+00:00 - trace: Mina was affected wotb_id 1222

2024-03-21T20:51:53+00:00 - trace: Trim indexes below block #133174

2024-03-21T20:51:53+00:00 - debug: Total tx count: 10937

2024-03-21T20:51:53+00:00 - trace: Mikhaella3448 was affected wotb_id 1223

2024-03-21T20:51:53+00:00 - trace: GeoffreyMichel was affected wotb_id 1224

2024-03-21T20:51:53+00:00 - trace: Rinnosuke was affected wotb_id 1225

2024-03-21T20:51:53+00:00 - trace: Trim indexes below block #133455

2024-03-21T20:51:53+00:00 - trace: maew was affected wotb_id 1226

2024-03-21T20:51:53+00:00 - debug: Total tx count: 10954

2024-03-21T20:51:53+00:00 - trace: ThomasRouyer was affected wotb_id 1227

2024-03-21T20:51:53+00:00 - debug: Total tx count: 11005

2024-03-21T20:51:54+00:00 - trace: Trim indexes below block #133761

2024-03-21T20:51:54+00:00 - trace: yannickjuchat was affected wotb_id 1228

2024-03-21T20:51:54+00:00 - debug: Total tx count: 11025

2024-03-21T20:51:54+00:00 - trace: Trim indexes below block #134047

2024-03-21T20:51:54+00:00 - trace: Erle was affected wotb_id 1229

2024-03-21T20:51:54+00:00 - debug: Total tx count: 11040

2024-03-21T20:51:54+00:00 - trace: Trim indexes below block #134328

2024-03-21T20:51:54+00:00 - debug: Total tx count: 11047

2024-03-21T20:51:54+00:00 - trace: Neluma was affected wotb_id 1230

2024-03-21T20:51:54+00:00 - trace: Trim indexes below block #134617

2024-03-21T20:51:55+00:00 - info: Getting chunk #540/2855 from 135000 to 135249 on peer g1.brussels.ovh

2024-03-21T20:51:55+00:00 - info: Getting chunk #541/2855 from 135250 to 135499 on peer g1v1.p2p.legal

2024-03-21T20:51:55+00:00 - info: Getting chunk #542/2855 from 135500 to 135749 on peer g1.cgeek.fr

2024-03-21T20:51:56+00:00 - info: Getting chunk #543/2855 from 135750 to 135999 on peer duniter-v1-g1.axiom-team.fr

2024-03-21T20:51:56+00:00 - info: Getting chunk #545/2855 from 136250 to 136499 on peer duniter.econolib.re

2024-03-21T20:51:56+00:00 - info: GOT chunk #540/2855 from 135000 to 135249 on peer g1.brussels.ovh

2024-03-21T20:51:56+00:00 - info: GOT chunk #541/2855 from 135250 to 135499 on peer g1v1.p2p.legal

2024-03-21T20:51:56+00:00 - info: GOT chunk #542/2855 from 135500 to 135749 on peer g1.cgeek.fr

2024-03-21T20:51:56+00:00 - info: Getting chunk #544/2855 from 136000 to 136249 on peer g1.brussels.ovh

2024-03-21T20:51:56+00:00 - debug: Total tx count: 11064

2024-03-21T20:51:56+00:00 - info: GOT chunk #543/2855 from 135750 to 135999 on peer duniter-v1-g1.axiom-team.fr

2024-03-21T20:51:56+00:00 - trace: Evejade was affected wotb_id 1231

2024-03-21T20:51:56+00:00 - trace: gaeloliv was affected wotb_id 1232

2024-03-21T20:51:56+00:00 - trace: JPGRAU was affected wotb_id 1233

2024-03-21T20:51:56+00:00 - trace: MimiMu was affected wotb_id 1234

2024-03-21T20:51:56+00:00 - info: GOT chunk #545/2855 from 136250 to 136499 on peer duniter.econolib.re

2024-03-21T20:51:56+00:00 - info: GOT chunk #544/2855 from 136000 to 136249 on peer g1.brussels.ovh

2024-03-21T20:51:56+00:00 - trace: Soln was affected wotb_id 1235

2024-03-21T20:51:56+00:00 - trace: Trim indexes below block #134903

2024-03-21T20:51:56+00:00 - trace: Pierreieni was affected wotb_id 1236

2024-03-21T20:51:56+00:00 - debug: Total tx count: 11079

2024-03-21T20:51:56+00:00 - trace: Pierro was affected wotb_id 1237

2024-03-21T20:51:56+00:00 - trace: Trim indexes below block #135163

2024-03-21T20:51:56+00:00 - debug: Total tx count: 11091

2024-03-21T20:51:56+00:00 - trace: LiJu was affected wotb_id 1238

2024-03-21T20:51:56+00:00 - trace: LucAstarius was affected wotb_id 1239

2024-03-21T20:51:56+00:00 - trace: Trim indexes below block #135423

2024-03-21T20:51:56+00:00 - debug: Total tx count: 11099

2024-03-21T20:51:56+00:00 - trace: Babarbaobab was affected wotb_id 1240

2024-03-21T20:51:57+00:00 - debug: Total tx count: 11141

2024-03-21T20:51:57+00:00 - trace: Trim indexes below block #135721

2024-03-21T20:51:57+00:00 - trace: NicoBoc was affected wotb_id 1241

2024-03-21T20:51:57+00:00 - trace: Rykian was affected wotb_id 1242

2024-03-21T20:51:57+00:00 - debug: Total tx count: 11173

2024-03-21T20:51:57+00:00 - trace: Trim indexes below block #136007

2024-03-21T20:51:57+00:00 - trace: Louis was affected wotb_id 1243

2024-03-21T20:51:57+00:00 - trace: GaelleKiers was affected wotb_id 1244

2024-03-21T20:51:57+00:00 - trace: Iguana was affected wotb_id 1245

Le deuxieme:

2024/03/21 20:47:04 blockchain.go:3117: Adding Centralities to updateList

2024/03/21 20:47:04 run.go:53: WotWizard Server version 5.11.3 Tools version 1.0.8

2024/03/21 20:47:04 blockchain.go:3117: Adding Blockchain to updateList

2024/03/21 20:47:04 blockchain.go:3244: Starting

2024/03/21 20:47:04 blockchain.go:3245:

2024/03/21 20:47:04 blockchain.go:1074: "DBase.data" created

2024/03/21 20:47:04 blockchain.go:1094: "DBase.data" opened

2024/03/21 20:47:04 blockchain.go:3038: "updating.txt" erased

2024/03/21 20:47:04 blockchain.go:3039: Looking for /app/data/duniter_default/updating.txt

2024/03/21 20:47:04 blockchain.go:3040:

2024/03/21 20:47:04 gqlReceiver.go:479: Listening on 0.0.0.0:8080 ...

2024/03/21 20:50:48 gqlReceiver.go:401: ***ERROR*** Incorrect JSON request: Void string

poka

21 March 2024 21:10

50

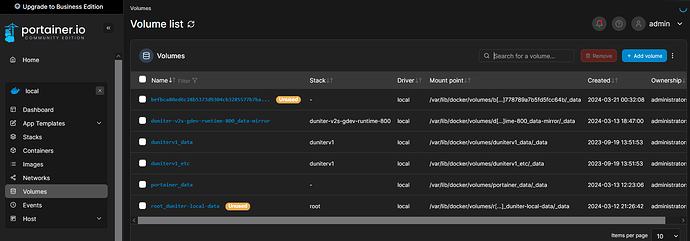

supprime bien le volume dataww de wotwizard avec de le lancer, comme tu as fait avant tu sais.

docker compose up -d --force-recreate pour forcer la recréation des container après avoir supprimer le volume dataww.

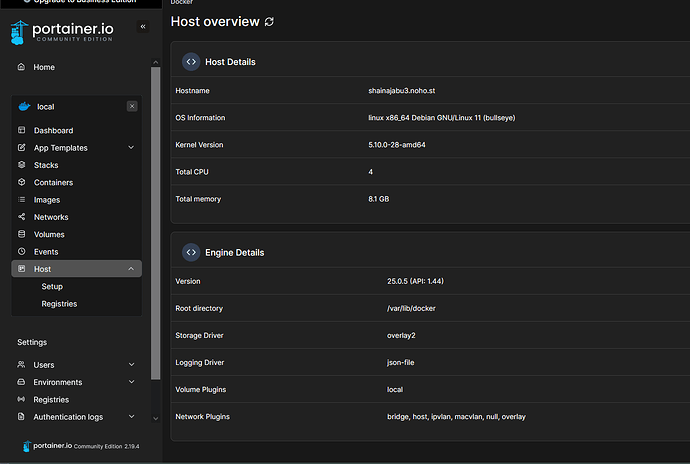

Je n’ai plus acces à localhost:9220 pour le panneau de configuration, comment le retablir?

poka

21 March 2024 21:28

52

Je ne peux pas t’aider sur portainer, désolé.

Log de wotwizard

2024/03/21 22:35:22 blockchain.go:3117: Adding Centralities to updateList

2024/03/21 22:35:22 run.go:53: WotWizard Server version 5.11.3 Tools version 1.0.8

2024/03/21 22:35:22 blockchain.go:3117: Adding Blockchain to updateList

2024/03/21 22:35:22 blockchain.go:3244: Starting

2024/03/21 22:35:22 blockchain.go:3245:

2024/03/21 22:35:22 blockchain.go:1074: "DBase.data" created

2024/03/21 22:35:22 blockchain.go:1094: "DBase.data" opened

2024/03/21 22:35:22 blockchain.go:3038: "updating.txt" erased

2024/03/21 22:35:22 blockchain.go:3039: Looking for /app/data/duniter_default/updating.txt

2024/03/21 22:35:22 blockchain.go:3040:

2024/03/21 22:35:22 gqlReceiver.go:479: Listening on 0.0.0.0:8080 ...

2024/03/21 22:47:19 gqlReceiver.go:401: ***ERROR*** Incorrect JSON request: Void string

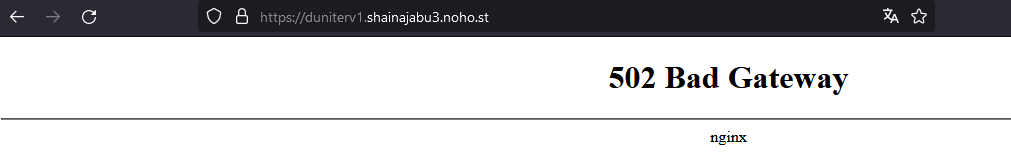

Non je me suis trompée ginspecte est statue eteint et url est en 502.

Je vais faire tournée duniter v1 pour le week end et je retenterai lundi ou mardi wotwizar-duniterv1.

1 Like

Pini

22 March 2024 17:47

55

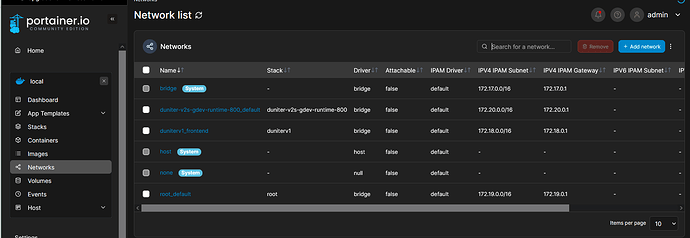

Salut, j’arrive un peu à la fin de la bataille

@poka : ça marche comment les interactions entre un noeud duniter et wotwizard ? Il faut partager le volume data entre les deux conteneurs, c’est ça ?

Pour l’image duniter_v1 je peux facilement ajouter une option qui active le stockage wotwizard. Il ne manque que ça ?

3 Likes

poka

22 March 2024 18:12

56

Oui je crois qu’il ne manque que ça

Pour le moment je n’ai testé (et mis en prod…) que avec un noeud duniter local sans docker, en montant le dossier ~/.config.duniter au bon endroit dans le container wotwizard.

Mais ça semble poser problème lorsqu’on veut partager un volume docker entre 2 containers, voir les échanges au dessus.

Je pense que ce sont ces deux lignes de mon Dockerfile qui posent problème:Dockerfile · dockeriser · gerard94 / WotWizard · GitLab

Après ça, si on monte le volume /app/rsrc/ dans le compose, cela écrase ce qui a été fait par ces deux lignes.

d’où le fait que je ne monte que /app/rsrc/duniter/System/ par defaut dans le compose, qui sont les données DB de wotwizard nécessaires pour la persistance.

1 Like

Pini

22 March 2024 18:15

57

Si j’active le stockage wotwizard sur mon noeud il faut que je resynchronise ?

poka

22 March 2024 18:19

58

Bonne question, je ne sais pas, je ne pense pas non. Tu dois voir le fichier duniter_default/wotwizard-export.db se créer, et duniter_default/updating.txt aussi. Mais faut attendre la prochaine arrivé de block pour voir ça arriver.

Je faisais cette commande pour checker l’arrivé du fichier annonçant l’update à WW:

inotifywait -m -e create --format '%w%f' /home/axiom/.config/duniter/duniter_default/ | while read file; do if [ "$file" = "/home/axiom/.config/duniter/duniter_default/updating.txt" ]; then echo "Le fichier updating.txt a été créé."; cat "$file"; fi; done

1 Like

Pini

22 March 2024 19:55

59

Oui j’ai bien ça.

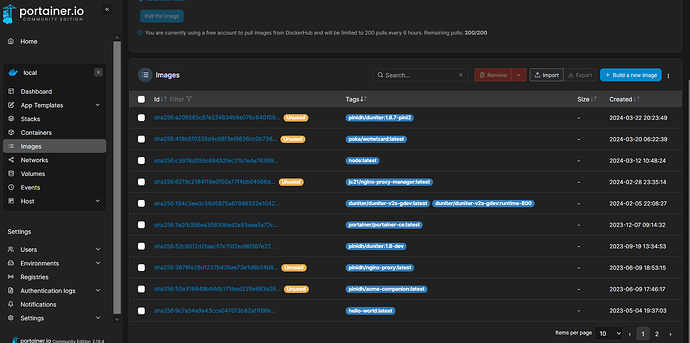

Je viens d’uploader une nouvelle image pinidh/duniter:1.8.7-pini2 qui implémente la configuration wotwizard via la variable DUNITER_WOTWIZARD (booléen).

Je maintenant voir du côté wotwizard.

1 Like

Pini

22 March 2024 19:59

60

Ces deux lignes devraient figurer dans l’entrypoint et non dans le Dockerfile. Ça pourrait suffire à résoudre le pb.

Je n’ai pas moyen de tester wotwizard moi-même car mes serveurs sont full.

2 Likes

poka

23 March 2024 08:25

61

Je viens de pousser une nouvelle image docker wotwizard où j’ai effectivement bougé cette conf dans le entrypoint.

@tatinetteb a tester du coup, avec le nouvelle image duniter de Pini, ajout de:

image: pinidh/duniter:1.8.7-pini2 pour le container duniter DUNITER_WOTWIZARD: "true" dans le container duniter Monter directement dataww:/app/rsrc dans le container wotwizard

docker compose pull pour tirer latest de wotwizard.

Je te remet le compose théorique que tu devrais avoir selon moi.@Pini est-ce que tu confirmes qu’au niveau des volumes ça te semble ok ainsi:

version: '3.8'

services:

duniter:

image: pinidh/duniter:1.8.7-pini2

restart: unless-stopped

environment:

DEBUG_ENTRYPOINT: "true"

DUNITER_AUTO_SYNC: "true"

DUNITER_SYNC_HOST: "duniter.pini.fr:443"

DUNITER_UPNP: "false"

DUNITER_BMA_ENABLED: 'true'

DUNITER_BMA_IP4: "0.0.0.0"

DUNITER_BMA_REMOTE_PORT: "443"

DUNITER_BMA_REMOTE_HOST: "$DNS_NAME"

DUNITER_WS2P_HOST: "0.0.0.0"

DUNITER_WS2P_PORT: '20901'

DUNITER_WS2P_PUBLIC: 'true'

DUNITER_WS2P_REMOTE_HOST: "$DNS_NAME"

DUNITER_WS2P_REMOTE_PORT: "443"

DUNITER_WS2P_REMOTE_PATH: "ws2p"

DUNITER_WOTWIZARD: 'true'

VIRTUAL_HOST: "$DNS_NAME"

VIRTUAL_PORT: "10901,20901:/ws2p"

LETSENCRYPT_HOST: "$DNS_NAME"

LETSENCRYPT_TEST:

volumes:

- data:/var/lib/duniter

- etc:/etc/duniter

networks:

- frontend

mem_limit: 2g

logging:

options:

max-size: "10m"

max-file: "3"

wotwizard:

image: poka/wotwizard:latest

restart: unless-stopped

ports:

- "8080:8080"

volumes:

- data:/app/data

- dataww:/app/rsrc

networks:

- frontend

volumes:

data:

etc:

dataww:

networks:

frontend:

name: reverse-proxy_bridge

1 Like

Pini

23 March 2024 08:58

62

Est-ce que wotwizard a vocation à écrire dans le volume data ? Sinon il faudrait le spécifier en lecture seule : data:/app/data:ro

Sinon ça me semble OK, à tester.

1 Like

poka

23 March 2024 09:08

63

Je crois qu’il est responsable de supprimer updating.txt une fois qu’il l’a traité, donc oui.

1 Like

J’ai relancé un noeud v1 avec votre compose couplé à Wotwizard, mais comme auparavant, sa synchro se bloque toujours au même bloc n°613499, ca ne va pas plus loin… La stabilisation et la mise en place d’un noeud pose de + en + de contraintes…

mon noeud est visible mais jamais synchro : https://g1.rendall.fr/

2024-03-24T08:36:06+00:00 - debug: Upgrade database...

2024-03-24T08:36:06+00:00 - info: Block resolution: 0 potential blocks after current#613499...

2024-03-24T08:36:06+00:00 - info: Web administration accessible at following address: http://0.0.0.0:9220

2024-03-24T08:36:06+00:00 - info: WS2P server 7GXQVx6U9tJVe4eLcFECv984XY5LdU9S7y7Gxc9Mvm4n listening on 0.0.0.0:20901

2024-03-24T08:36:06+00:00 - info: BMA server listening on http://0.0.0.0:10901

2024-03-24T08:36:06+00:00 - warn: Local node is not a member. Waiting to be a member before computing a block.

2024-03-24T08:36:06+00:00 - info: WS2P: init: bundle of peers 1/1

2024-03-24T08:36:06+00:00 - info: Sibling endpoints:

2024-03-24T08:36:06+00:00 - info: BMA access: g1.rendall.fr:443

2024-03-24T08:36:06+00:00 - info: WS2P access: g1.rendall.fr:443 ws2p

2024-03-24T08:36:06+00:00 - debug: Generating server's peering entry based on block#613470...

2024-03-24T08:36:06+00:00 - info: [7GXQVx6U] ⬇ PEER 7GXQVx6U 613470-0

2024-03-24T08:36:06+00:00 - info: POST Peer 7GXQVx6U9t#613470 to 1 peers

2024-03-24T08:36:06+00:00 - info: [7GXQVx6U] ✔ PEER 7GXQVx6U 613470-0

2024-03-24T08:36:06+00:00 - info: Next peering signal in 359 min

2024-03-24T08:36:21+00:00 - info: WS2P: Could not connect to peer HBsi19D9 using `WS2P g1v1.p2p.legal 443: WS2P connection timeout`

2024-03-24T08:36:21+00:00 - debug: WS2P: init: failed connection

2024-03-24T08:36:21+00:00 - info: Block resolution: 0 potential blocks after current#613499...

2024-03-24T08:36:21+00:00 - info: Block resolution: 0 potential blocks after current#613499...

ness

24 March 2024 09:27

65

cinq gigas de cache ne suffisent pas, mets minimum six et pour etre tranquile par la suite si besoin de resynchro dans six mois huit gigas (1024 x 8)

ensuite il faut savoir que la 1.8.7 n’ a pas de logs de synchro puis qu’ en utilisant la .6 mes synchro passent à 1oo% en moins huit heures sur une vm de moyenne puissance

(ps un petit tuto sur le node max dans divers environnements JavaScript Heap out of memory error [Solved] | bobbyhadz )

@joss.rendall si tu n’ as pas huit gigas de ram rajoute du swap sur un ssd mve sans quoi c’ est très long

j’ai un VPS : 8vCore@2.4Ghz avec 16Go deRAM, pourtant ca bloque quand meme à chaque fois au bloc n°613499… j’ai voulu testé avec une réduction de la resource RAM mais ca ne change rien, alors je viens de relancer le conteneur à neuf avec effacement préalable des volumes sans modif du NODE_OPTIONS…on verra demain

ness

24 March 2024 21:23

67

ce n’ est pas une réduction que l’ on recherche avec le node max mais un débridage, d’ origine il n’ est pas suffisant pour notre chaine (512Mega)

une synchro complète prend actuellement entre cinq et six gigas de cache, si t’ as le node max à cinq, ton node est limité lors de la synchro

Bonjour,

J’ai tenté plusieurs fois aujourd’hui.

La première tentative a consisté à arrêter le noeud v1 dans Portainer et à supprimer tous les anciens noeuds WotWizard. J’ai ensuite copié le fichier de compose dans Portainer. Malheureusement, rien n’a fonctionné, avec un message d’erreur du côté de Duniter indiquant que le noeud n’était pas membre, et une erreur JSON du côté de WotWizard.

Pour la deuxième tentative, j’ai supprimé le noeud précédent et remplacé “$DNS_NAME” par l’URL de mon noeud Duniter. Bien que Duniter ait téléchargé les blocs, l’erreur persistait du côté de WotWizard. De plus, localhost:9220 ne fonctionnait pas, mon noeud était éteint sur https://ginspecte.mithril.re .

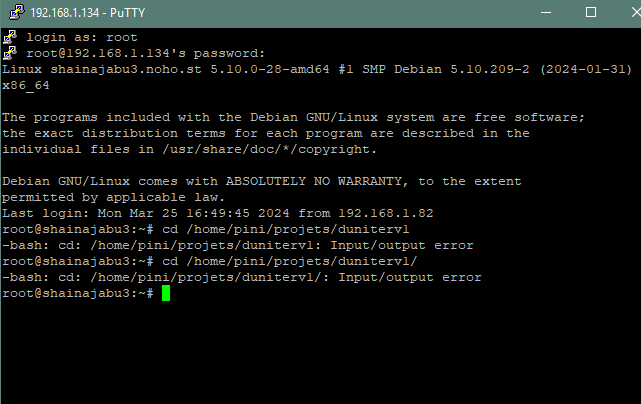

Enfin, pour le troisième essai, j’ai supprimé le noeud précédent et j’ai essayé de me connecter via Putty au noeud créé par @Pini , ce qui a abouti à ce message d’erreur.

Je suis passé par l’interface graphique de Debian pour copier le docker-compose, puis j’ai ajouté les lignes que tu m’as recommandées. Malheureusement, je n’ai pas réussi à exécuter docker compose pull sur le nœud de Pini. J’ai redémarré l’ordinateur, puis dans Portainer, j’ai redémarré le nœud. Duniter fonctionne correctement, j’ai accès à localhost:9220 et tout fonctionne bien sur ginspecte.

1 Like