Tu allais attendre jusqu’à quand pour remonter ce problème majeur au projet Silkaj ? Il faut le dire quand quelque chose ne va pas. Ça aide beaucoup le projet. On se rend compte souvent qu’on rencontre le même problème que d’autres personnes. Ça sera pour la prochaine fois

Tuxmain a déjà bien répondu aux questions, je vais y ajouter mon apport.

J’ai rajouté « source de monnaie ». Ça devrait déjà éclaircir le point sans le détail donné par Tuxmain qui est très bien.

Oui, avec ce contournement ça me semble une bonne piste stable :

Oui, en augmentant la durée entre l’emisison des documents de transactions. Plus de cinq minutes pour être sûr. Mais, c’est surement pas suffisant pour être certain que la transaction passe.

Non, comme expliqué par Tuxmain.

Je sais pas très bien. Voyont voir ce que disent les paramètres de Duniter :

curl g1.duniter.org/blockchain/parameters

{

"currency": "g1",

"c": 0.0488,

"dt": 86400,

"ud0": 1000,

"sigPeriod": 432000,

"sigStock": 100,

"sigWindow": 5259600,

"sigValidity": 63115200,

"sigQty": 5,

"sigReplay": 5259600,

"idtyWindow": 5259600,

"msWindow": 5259600,

"msPeriod": 5259600,

"xpercent": 0.8,

"msValidity": 31557600,

"stepMax": 5,

"medianTimeBlocks": 24,

"avgGenTime": 300,

"dtDiffEval": 12,

"percentRot": 0.67,

"udTime0": 1488970800,

"udReevalTime0": 1490094000,

"dtReeval": 15778800

}⏎

├────────────────────────────────────────────────────────────────────────────┼─────────────────┤

│ Certification life-span in the sandbox │ a month │

├────────────────────────────────────────────────────────────────────────────┼─────────────────┤

│ Identity life-span in the sandbox │ a month │

├────────────────────────────────────────────────────────────────────────────┼─────────────────┤

│ Membership life-span in the sandbox │ a month │

├────────────────────────────────────────────────────────────────────────────┼─────────────────┤

{sig,idty,ms,}Window sont définis. Par contre pour la transaction, le document le plus utilisé, txWindow n’est pas défini. Ça doit surement être la même valeur.

Après, comme dis Tuxmain, chaque mainteneur de nœud pourrait mettre en place des règles différentes sur la mempool de son nœud pour gérer l’expiration des documents.

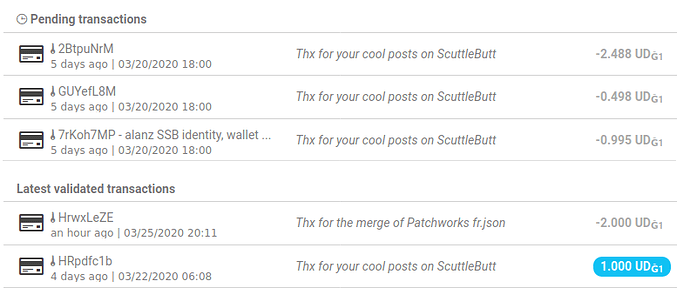

Concernant la sélection des sources de monnaie dans Silkaj, je ne vois pas trop pourquoi ce problème a lieu. Silkaj enlève les sources des transactions trouvés dans les pendings. Peut-être qu’il est plus rapide que Duniter à mettre à jour ces indexes, soit c’est un bug dans Silkaj. À investiguer.